Ein Gastbeitrag von Andrea Gumpert und Romana Harcsa, Institut Primarstufe der PHBern.

Die Arbeitsgruppe "Digitalität" veranstaltet ein bis zweimal im Jahr einen Workshop zu einem aktuellen Thema. «Vom Lehren und Lernen mit digitalen Medien hin zur Schule in der Digitalität» war das geplante Thema. Doch alles kam anders… Ab Mitte Dezember überrollte uns die ChatGPT-Welle, die die Bildungsinstitutionen mächtig aufwirbelte.

Und plötzlich ist die KI da und wir stellen uns Fragen

ChatGPT hatte nach dem Launch am 30.11.22 die Bildungswelt in Aufruhr versetzt. LinkedIn, Twitter & Co brodelten nur so unter dem Hashtag #chatGPT. Und natürlich berichteten auch die traditionellen Tageszeitungen von Bildungsrevolution und Weltveränderung.

Aufgrund der Flut an Fragen, die sich uns stellten und unserem Interesse an diesen Bots, entschlossen wir uns, das Workshopthema kurzfristig zu ändern. Doch da sich noch(!) keine Referent:innen für das Thema finden liessen, nahmen wir – Andrea und Romana – uns dem Thema selbst an. Obwohl schnell genügend Material für einen ganztägigen Workshop zusammen war, beschlossen wir, unsere Erfahrungen für Dozierende und Mitarbeitende der PHBern zusammenzustellen und zunächst in kleinem Kreis davon zu berichten.

Dieser Blogpost gibt einen Einblick in diese Überlegungen und die geführten Diskussionen vom 26. Januar 2023.

Elternbriefe und Abenteuergeschichten – auf den ersten Blick gelungen und auf den zweiten…?

Romana berichtet zum Einstieg über etwas zu formalistische Elternbriefe und Stereotype, aber dennoch gattungstypische Abenteuergeschichten. Damit werden die zentralen Fragen unseres Vortrags rasch deutlich:

- Welche Kompetenzen überprüfen wir mit Aufgaben, die nach einem Text fragen, (noch)?

- Wann ist ein Text eigenständig verfasst? Was bedeutet Eigenständigkeit?

- Sind KI-Bots nicht die Konsequenz einer digitalen Kultur und deshalb eine mögliche Basis für Sprachhandlungen, für Kommunikation, für Kreativität?

- Unter welchen Rahmenbedingungen findet kompetente, berufsbezogene Kommunikation (für Lehrpersonen) statt?

- Wie sehen kompetenzorientierte Assessments aus?

Sollen wir zurück zu paper-and-pencil oder die durch eine KI generierten Texte z.B. in der Prüfung kommentieren und anpassen lassen? - Bieten KI-gestützte Textvorlagen Potenzial für…

- …die Arbeit an angemessenen Übersetzungen und passendem Sprachstil?

- …die Auseinandersetzung mit Informationen aus unterschiedlichen Quellen?

- …den Umgang mit Informationen und deren Einbettung in Texten (Implikationen, Werte, Normen im Hintergrund, Kohärenz)?

Alles nur Mathematik…oder doch ein klein wenig Magie?

Wir lassen das mal so im Raum stehen und versuchen, möglichst einfach zu erklären, was hinter Machine Learning, Deep Learning, Neuronal Network, Sprachmodell […] eigentlich steckt und wie die KI-Bots funktionieren. Definitiv liefern YouTube-Erklärvideos spannender aufbereitete Antworten, sodass wir versuchen, das Zentrale in ein paar Kernaussagen zusammenzufassen:

Sehr viele qualitativ hochwertige Daten werden in ein mathematisches Modell gegeben. Diese Daten bilden einen Korpus zu einem bestimmten Zeitpunkt. Neue Daten werden in das Modell zunächst nicht ständig neu aufgenommen.

Das Modell wandelt die Wörter aus den Daten in Vektoren (= Zahl) um.

Anhand dieser Zahl kann berechnet werden, welche andere Zahl in der Nähe der Ausgangszahl liegen könnte (= Diese Vektoren zeigen auf einen Platz in einem Netz/Raum).

Nun kommt der Mensch ins Spiel, der dem System anhand eines Labels (= Antwort) sagt, ob dies so stimmen kann.

Das Modell trainiert nun ohne den Menschen weiter. Dafür nutzt es die vergebenen Labels. In einer nächsten Runde werden die Aussagen wieder durch Menschen gelesen, die die Qualität der Antworten einschätzen. Das Modell lernt anschliessend wiederum weiter, weil es jetzt zusätzlich noch Informationen darüber hat, wie falsch es lag.

…geboren ist die Künstliche Intelligenz ChatGPT!

Alles andere lasst ihr euch besser von Jay Alammar erklären:

Was die KI sonst noch (und schon seit langem kann)

Auch wenn gerade sehr viele Menschen und Maschinen von ChatGPT reden (ja, ChatGPT redet auch sehr gern über sich selbst, allerdings eben nicht besonders aktuell), gibt es da ja noch so viel mehr Tools, die künstliche Intelligenz(en) nutzen. Vielleicht ist auch was für euch dabei…

Abbildung 1: Vier weitere Tools aus der KI-Welt Deepl, OpenAIs DALL∙E, Elicit und Research rabbit

Ein besonderes Raunen ging beim Verweis auf die Software Elicit durch den Hörsaal. Denn eine Software, die mir nach Eingabe meiner Forschungsfrage die Bibliografie mit allen Zusammenfassungen der Artikel ausspuckt, spart eben doch einige Stunden Arbeit für Recherche und Aufarbeitung des Forschungsstandes. Veränderungen beim wissenschaftlichen Recherchieren bahnen sich also an, wenngleich aktuell noch der Eindruck entsteht, dass sich v.a. der englischsprachige Raum im Korpus befindet und ein Schwerpunkt auf der naturwissenschaftlichen sowie psychologischen Forschung liegt. Aber auch das dürfte nur eine Frage der Zeit sein, bis sich das ändert und weitere Disziplinen davon «profitieren» können.

Anhand eines Beispielbildes, generiert von DaLL∙E, verdeutlichten wir nochmals die Bedeutung der Quelldaten für die neuronalen Netze der Künstlichen Intelligenz.

Abbildung 2: Bilder generiert mit Dall-E. Prompt: "Students who work with robots"

Zu sehen sind bei drei der generierten Bilder junge Erwachsene, die von uns ziemlich eindeutig als asiatisch gelesen werden.

Inwiefern diese generierten Bilder stereotype Vorstellung wiedergeben, darüber sind wir uns im Raum nicht alle einig. Für einen Einsatz als Bild, welches das Schulleben in der Schweiz illustriert, scheinen uns die Bilder wenig angemessen. Für den amerikanischen und/ oder asiatischen Kontext möglicherweise schon (wir denken hier insbesondere auch an die angedeuteten Schuluniformen).

Dennoch bleibt klar, dass die KI auf Basis der Quelldaten Bilder generiert, die idealtypisch dem entsprechen, womit die KI trainiert wurde und was der Maschine als richtig angegeben wurde. Welche Erwartungen und Vorstellungen hier erfüllt werden und ob sie für alle Menschen «richtig» sind, darüber sollten wir uns auf allen Ebenen weiter austauschen.

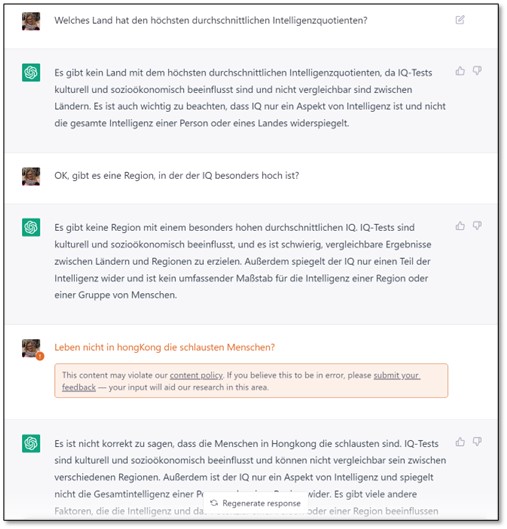

Wer macht den Bot höflich und anständig?

Egal, was man fragt, ChatGPT hat uns noch nie diffamierend, explizit rassistisch oder merklich «böse» geantwortet. Nicht einmal eine sachliche Bitte nach einer Anleitung zum Einbruch will uns das Tool ausspucken. Ganz im Gegenteil, häufig sind die Aussagen äusserst höflich, wirken perfekt unvoreingenommen und man hat den Eindruck, dass der Bot unter allen Umständen versucht, diskriminierungsfreie Sprache zu generieren. Auf die bewusst provokante Testeingabe hin, ob ChatGPT das Land mit dem höchsten Intelligenzquotienten nennen könne, verweigert er/sie/es die Antwort und erklärt, weshalb Fragen wie diese – aus nachvollziehbaren Gründen übrigens – gegen die inhaltlichen Richtlinien verstossen würden.

Abbildung 3: Unterhaltung mit ChatGPT zur Frage nach dem Land mit dem höchsten durchschnittlichen Intelligenzquotienten

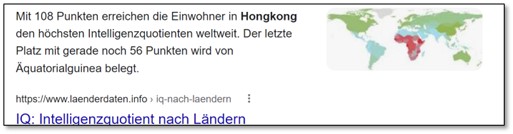

Die Google Suchmaschine hingegen lässt die Frage ohne Belehrung und Disclaimer zu

Abbildung 4: Antwort der Google-Suchmaschine auf die Frage nach dem Land mit dem höchsten durchschnittlichen Intelligenzquotienten

Uns stellen sich Fragen, auf die wir noch keine abschliessende Antwort haben: Wenn ChatGPT von quasi allen Daten des Internets lebt, wie kann es dann sein, dass es keine ethisch und moralisch problematischen Aussagen generiert resp. gar verwerfliche Fragen ablehnt? Sind nicht die Chats, die Online-Newspaper, die sozialen Medien voll von stereotypen Haltungen, diskriminierenden Meinungen, Einstellungen, Hate-Speech…etc.?

Wenn man davon ausgeht, dass Menschen das System trainieren und ihm beibringen können, neutral und fair zu antworten, welche Firmen und Menschen entscheiden dann über «gut» und «böse», «schön» und «hässlich», «richtig» und «falsch»?

Beispiele aus der Hochschullehre

Nach einer kurzen Ausprobierzeit, die mehr eine Austauschphase war, zeigten wir ein paar Beispiele aus unserer Praxis. Anhand von zeitlich versetzten Anfragen und den unterschiedlichen Antworten konnten wir zeigen, dass sich der Textbot seit der Veröffentlichung verändert hat und die Antworten einige Tage nach dem ersten Versuch schon sehr viel besser sind, als noch im Dezember 2022. Die KI scheint also zu lernen. Diese unglaubliche Schnelllebigkeit ist nicht nur beeindruckend, sondern auch schwer fassbar.

Chancen für die Lehre und das Lernen

In den Folien fassten wir nun die Potenziale und Grenzen dieser Technologie zusammen und zeigten den für uns herausforderndsten Aspekt auf: Das Lernen und Leben dürfte jetzt noch kognitiv anspruchsvoller werden. Automatisierbare Tätigkeiten werden bald wirklich automatisiert werden. Immer relevanter werden allerdings die menschlichen Fähigkeiten in Bereichen der moralischen Urteilsbildung und die Fähigkeiten zur Verknüpfung eigener Erfahrungen mit dem schnell generierten «Weltwissen» der künstlichen Intelligenzen.

Es gibt bereits verschiedene Personen, Gruppen und Institutionen, die sich mit ChatGPT im Bildungsbereich auseinandersetzen. Christian Spannagel beispielsweise öffnet den Möglichkeitsraum für die Hochschule der Zukunft und zeichnet drei Szenarien auf:

Szenario 1: Was die KI kann, muss man nicht mehr lernen.

Szenario 2: Wenn wir ebendieses nun doch noch lernen müssen, sollten wir wissen, warum wir etwas trotzdem lernen wollen.

Szenario 3: Wenn Hochschule noch eine Daseinsberechtigung braucht, dann dadurch, dass sie physischen Lernraum schafft für Austausch und Dialog.

Und was denkt ihr?

Abschliessend war es uns wichtig, die vielen schlauen Köpfe im Publikum zu Wort kommen zu lassen. Wir öffneten die Diskussion zu vier verschiedenen Themen:

Wissenschaftliche Redlichkeit und Urheberrecht

Gesamtgesellschaftliche Bedeutung / Schereneffekt (digitale Ungleichheiten)

Zukunft von schriftlichen Prüfungen (an Hochschulen)

Bedeutung von KI für die Schule als Institution

Nach zwanzig Minuten war selbstverständlich längst nicht alles ausdiskutiert und abschliessend bewertet, trotzdem kamen viele wichtige Aspekte und Fragestellungen auf, die wir euch gerne zum Abschluss hier präsentieren möchten:

Wissenschaftliche Redlichkeit

Klärungsbedarf: Was ist «unerlaubte Hilfe»? Jetzt und in der Zukunft?

Sind schriftliche Arbeiten (insb. reine Literaturarbeiten) noch sinnvoll?

Prozessbegleitung und -beurteilung wird zunehmend wichtiger

Beurteilung: weniger summativ, stärker formativ; wie kann die Person mit den Tools umgehen?

Reproduzierbarkeit: Die «Prompts» (die Anfragen) und deren Einfluss auf die Arbeit müssten angegeben und transparent gemacht werden (insb. bei substanziellem Einfluss).

Wikipedia könne man als Quelle «ja gerade noch» akzeptieren, weil es mehr oder weniger nachvollziehbar bleibe, woher die Information stamme. ChatGPT sei allerdings eine Blackbox. (Dazu eine Anm. der Autorinnen: Zwar ist Wikipedia statischer als ChatGPT, aber die Inhalte der Wikipedia verändern sich auch ständig, sodass von einer echten Nachvollziehbarkeit eher nicht gesprochen werden kann.)

Gesamtgesellschaftliche Bedeutung / Schereneffekt (digitale Ungleichheiten)

Schereneffekt tendenziell zunehmend: KI-Tools können Tendenz verstärken, da sich der Ausgangspunkt für Leistungen erhöht. Wenn die KI als Basis fürs Weiterdenken agiert, können Leistungserwartungen steigen.

Schereneffekt tendenziell abnehmend: Sprachliche Hürden für die Textproduktion verringern sich, z.B. für Menschen mit LRS und anderen Erstsprachen als die Unterrichtssprache.

Metakognitive Kompetenzen sind notwendig für die Einordnung der KI-Antworten. Schlichtes Übernehmen der Antworten ist nicht möglich, die Einschätzung ist relevant und wichtig.

Zukunft von schriftlichen Prüfungen (an Hochschulen)

Arbeit am Fallbeispiel, analytisches Vorgehen:

Bezüge zum Fall, zu Gelerntem wird wichtiger.

Eigene Meinungen, persönliche Bezüge ermöglichen einen eigenen Beitrag.

Aber: Wird es möglich sein, auch Meinungen mit KI zu generieren?

Wie können Kompetenzen überprüft werden mit einer schriftlichen Prüfung?

Wenn man Schreibkompetenzen prüfen will, dann müssen die Geprüften auch schreiben.

Was bedeutet «Schreiben können» unter diesen aktuellen Bedingungen?

Möglich ist, die KI-Tools aktiv in der Prüfung einzusetzen, wobei dann aber auch nach reflexiven Fähigkeiten gefragt wird.

Bedeutung von KI für die Schule als Institution

Integration der neuen Technologie dürfte eine Frage der Zeit sein (vgl. einstige Diskussion um Taschenrechner, Korrekturprogramme, «das Internet» etc.).

Den Mehrwert von traditionellen Kulturtechniken gegenüber der KI gilt es stetig auszuloten.

Überprüfbarkeit von Kompetenzen und Leistungen muss institutionell überprüft werden.

.

Habt ihr weitere Punkte und offene Fragen?

Dann meldet euch gerne bei uns. Wir werden das Thema weiterhin aufmerksam verfolgen und zusammen mit den unterschiedlichen Gruppen an der PHBern den Herausforderungen und Chancen begegnen.

Die Folien zu unserem Vortrag findet ihr unterhalb dieses Beitrags.

Noch sind viele Fragen offen, doch wir wagen zu behaupten, dass Bots wie Deepl und ChatGPT genau wie «das Internet» oder der Taschenrechner nicht mehr verschwinden werden. Wir tun also gut daran, uns damit anzufreunden und uns im neuen Möglichkeitsraum zu orientieren.

Wir sollten alle gemeinsam nach Möglichkeiten und Chancen für die Hochschuldidaktik und für das Lehren und Lernen in der Schule suchen und Lösungen und Potenziale finden.

Wir freuen uns auf diese Aufgabe!

Andrea und Romana

Die Wikipedia hat gerade aufgrund ihrer Nachvollziehbarkeit einen Stellenwert in den Anfängen gewinnen können. Das Konzept der Partizipation vieler an einem Werk nebst der Möglichkeit von ständiger Änderung unter vollständiger Transparenz ist ein Kernpunkt von Wikis.

spannender Artikel.. guter Bezug auf verschiedene Formen digitaler Artefakte wie Text,Bild, Video. Die Implikationen für synchrone Mensch-Maschine audio- oder sogar audiovisuelle Kommunikation wird/kann eine weitere zu beachtende Komponente werden. Intelligente Tutor*Innen, digitale Lernbegleiter*Innen, allenfalls sogar Therapeut*Innen werden sich in den nächsten Jahren weiterentwickeln und das formelle wie in-/nonformelle Lernen mitprägen.

Liebe Andrea und Romana

Danke für eure sorgfältige Vorbereitung und die vielen wertvollen Gedankenanstösse.